LES ASTRONEWS de

planetastronomy.com:

Mise

à jour : 2 Janvier 2018 JOYEUSE ANNÉE

2018 À TOUS !!

Conférences et Évènements :

Calendrier .............. Rapport

et CR

Prochaine

conférence SAF « Une vie d’astronaute et de nouvelles missions » par

Claudie Haigneré

astronaute ESA le Vendredi 12 Janvier 2018

.

Réservation à partir du 16 Dec en cliquant sur la ligne réservation

(il ne reste que quelques places)

La suivante : « Les formes de l’espace, du trou noir au

multivers. » par JP Luminet

le vendredi 16 Février à 19H00 (résa > 13 Janv)

Liste

des conférences SAF en vidéo. (pas encore à jour!)

Astronews précédentes :

ICI

dossiers à télécharger par ftp :

ICI

ARCHIVES DES ASTRONEWS

: clic sur le sujet désiré :

Astrophysique/cosmologie

;

Spécial Mars ;

Terre/Lune

;

Système solaire ;

Astronautique/conq

spatiale

;

3D/divers

;

Histoire astro

/Instruments ;

Observations

;

Soleil

;

Étoiles/Galaxies ;

Livres/Magazines ;

Jeunes /Scolaires

Certains peuvent recevoir en double ces news, car ils sont

inscrits sur plusieurs listes. J’en suis désolé.

Sommaire de ce numéro :

Les amas de galaxies : CR de la conf SAF de F Durret du 15 Dec. 2017.

(02/01/2018)

Exoplanètes : CR de la conf de P Léna (Institut) du 12 Dec. 2017.

(02/01/2018)

Recherche de la matière noire : CR de la conf SAF (Cosmologie) avec M

Cirelli du 16 Dec. 2017. (02/01/2018)

Synchrotron Soleil : CR de la visite Vega du 7 Dec. 2017.

(02/01/2018)

Astronomie Gamma : CR conf IAP de H Sol du 5 Déc. 2017.

(02/01/2018)

Expo météorites : CR de la visite SAF du 4 Déc. 2017 au MNHN.

(02/01/2018)

François Forget :

Un nouvel Académicien des Sciences. (02/01/2018)

Nicolas Biver :

Médaille Arago. (02/01/2018)

Cosmologie : Un

article de vulgarisation de Denis Gialis.

(02/01/2018)

Exoplanètes :. Gliese 436b ne tourne vraiment pas

rond ! (02/01/2018)

Bizarre : Une étoile qui ne voulait pas mourir !

(02/01/2018)

JUNO :.Des

détails sur la grande tache rouge. (02/01/2018)

CÉRÈS :.Une explication pour les nombreux bright spots.

(02/01/2018)

Galileo :.Ariane

5 lance 4 nouveaux satellites (19 à 22) de la constellation.

(02/01/2018)

Ariane 6 : Du nouveau : des moteurs et des décisions.

(02/01/2018)

Vu d'en haut :.Toulouse.

(02/01/2018)

Disparition :

Alain Souchier nous a quittés ! (02/01/2018)

Un site Internet

à découvrir :.NASA Image of the Day Gallery.

(02/01/2018)

FRANÇOIS

FORGET : UN NOUVEL ACADÉMICIEN DES SCIENCES.

(02/01/2018)

Je suis particulièrement content d’annoncer, pour ceux qui ne le

savent pas encore, que notre ami

François Forget

de l’IPSL (LMD) a été nommé académicien des Sciences en Décembre 2017.

Nous lui présentons toutes nos félicitations pour cette

nomination bien méritée.

(Il a été nommé en même temps que Jean Jouzel, comme indiqué dans

ce communiqué)

François est bien connu de nos lecteurs, il est Directeur de

recherche au CNRS, en poste au Laboratoire de Météorologie Dynamique (LMD) ,

Institut Pierre Simon Laplace (IPSL) Université P. et M. Curie.

Il a de nombreuses fois donné des conférences dans le cadre de la

SAF, de Vega et d’autres institutions.

Signalons qu’il a été chercheur à la NASA (Ames) après avoir été

au CNES notamment. Thèse sur la planète Mars, sa préférée !

Il est très impliqué dans les modèles numériques du climat des

planètes comme Mars, ou même Pluton.

Il participe activement aux programmes des sondes spatiales

suivantes : Mars Express, New Horizons ; Exomars et Insight.

Son cursus

professionnel complet.

Encore bravo François et comme on dit là-bas : Keep up the good

work !!!

NICOLAS

BIVER : MÉDAILLE ARAGO.

(02/01/2018)

Encore une autre décoration ; Nicolas Biver, astronome du LESIA

et membre de la SAF a reçu, en toute intimité, la médaille Arago de l’Académie

des Sciences le 21 Nov 2017.

Nicolas est trop modeste pour avoir prévenu un large cercle de

personnes, aussi, l’avons-nous su un peu tard.

Néanmoins, cher Nicolas, accepte toutes nos félicitations.

La séance de remises des prix est sur

le site de l’Institut.

COSMOLOGIE : UN ARTICLE DE VULGARISATION DE DENIS GIALIS.

(02/01/2018)

Denis Gialis est astrophysicien, et il est un peu excédé par

toutes les théories cosmologiques

propagées par des non scientifiques.

Il veut remettre les choses d’aplomb.

À cet effet il m’a envoyé un (long) texte de vulgarisation sur ce

sujet qu’il m’autorise à publier dans ces astronews.

Je le publie mais on peut aussi le trouver complet sur

astrosurf.

C’est un excellent résumé de la situation scientifique actuelle.

Cosmologie et théorie du Big Bang : un état des lieux

Par

Denis GIALIS, astrophysicien

La

cosmologie a connu ces dernières années une évolution sans précédent :

l’avènement de nouveaux instruments d’observation, comme - par exemple – les

satellites WMAP ou Planck, a permis de rassembler un exceptionnel ensemble de

nouvelles données scientifiques qu’il convient d’analyser, de comprendre et

d’expliquer.

La

confrontation régulière entre ces données et la mise en place théorique de

modèles cosmologiques cohérents est à l’origine d’une effervescence scientifique

remarquable dans une discipline encore et toujours en plein essor.

Le

modèle standard cosmologique, construit autour de l’idée centrale que constitue

le Big Bang, a connu de nombreux ajustements au cours des dernières décennies.

S’accordant souvent avec succès aux nouvelles contraintes observationnelles, il

reste tout de même certaines (de trop nombreuses !) zones d’ombre que ce modèle

ne parvient pas à mettre en lumière et qui sont la source d'intenses débats dans

la communauté scientifique.

C’est

la raison pour laquelle ce modèle a des détracteurs : cependant, aucun de ces

détracteurs n’est aujourd’hui en mesure d’apporter un modèle scientifique aussi

satisfaisant qui expliquerait l’ensemble des observations réalisées depuis un

siècle.

Alors

que faire ? Plusieurs voies sont possibles aujourd’hui : doit-on, et si oui,

comment peut-on améliorer ce modèle ?

Faut-il, pourquoi pas, changer totalement notre vision de l’Univers ? Ou bien,

faut-il réinventer toute une partie de la physique dans une approche

unificatrice ?

Toutes

ces questions sont délicates et restent parmi les plus difficiles de la science

moderne.

Mais

avant d’aller plus loin,

rappelons ce que l’on appelle la cosmologie.

La

cosmologie s’intéresse à l’étude globale de l’Univers, ce dernier étant défini

comme l’ensemble de tout ce qui existe physiquement.

Son

objet est de comprendre et d’expliquer la formation des différentes structures

(galaxies, amas de galaxies, superamas, …) que l’on observe aujourd'hui dans

l’Univers et d’établir les liens existants entre ces dernières tout en les

replaçant dans un contexte d’étude globale de l’Univers, de son histoire et de

son évolution.

Cette

vision globale atteint son paroxysme lorsque certains cosmologistes ne

s’intéressent qu’à la forme géométrique ou à la topologie de l’Univers sans

avoir trop besoin de se soucier de la nature des objets qu’il contient, mais

seulement, peut-être, de son contenu énergétique.

C'est

d'ailleurs le sens même des équations d'Einstein : la géométrie et le contenu

énergétique de l'espace-temps sont étroitement liés. D’autres cosmologistes, en

revanche, s’intéressent plus au contenu « moyen » de l’Univers, c’est-à-dire à

l’abondance relative, et à son évolution au cours du temps, de ses différents

constituants possibles. De la même façon, certains essaient, par exemple, de

déterminer la répartition dans l’Univers de son contenu visible et invisible par

des observations directes et indirectes : on parle alors de cosmologie

observationnelle, et ses limites sont celles de l'Univers observable.

Enfin,

une partie des cosmologistes est spécialisée dans les aspects théoriques liés à

la naissance même de l’Univers et à sa première seconde d’existence (!). On

parle alors de cosmologie primordiale et le Big Bang est son point de départ.

Les compétences requises font alors appel aux disciplines fondamentales de la

physique : physique des particules, théorie quantique, et ainsi que toutes les

théories émergentes (théorie des cordes et supercordes, gravité quantique à

boucles…).

Pour

mieux comprendre les limites du modèle standard, il est bon de se demander

comment, de façon générale, se construit un modèle cosmologique.

L'objet physique étudié, l'Univers, a la particularité, par définition, d'être

unique et non reproductible ce qui, contrairement à de nombreux autres

phénomènes physiques, empêche toute comparaison et toute démarche expérimentale

de nature statistique.

En

outre, nous sommes des observateurs placés en un point précis de l'Univers,

c'est-à- dire à

l'intérieur de l'objet que l'on veut étudier, que ce soit en matière de

position spatiale ou bien d'instant d'observation.

La

vision que nous pouvons avoir de l'Univers est de ce fait très particulière et

très limitée.

En

effet, la finitude de la vitesse de transmission d'informations - via la

lumière, par exemple - fait que l'Univers observable ne constitue qu'une toute

petite partie de l'Univers tout entier.

Cette

posture scientifique, fondamentalement limitée, est donc peu confortable.

Comment, dès lors, imaginer et concevoir ce qui se passe ailleurs et partout

dans l'Univers et à tout autre instant de son histoire ?

C'est

l'un des problèmes fondamentaux de tout modèle cosmologique.

Il en

résulte au moins deux postulats de départ : le premier est que tout modèle

cosmologique se doit de proposer une solution scientifique probable permettant

de rendre compte de l'ensemble des observations effectuées. Cette solution peut

très bien ne pas être unique et rien ne permet, d'ailleurs, de prouver une

éventuelle unicité.

Le

second postulat est que les lois de la physique que l'on observe localement –

sur Terre, dans les laboratoires et dans notre environnement proche - sont

valables en tout autre point de l'Univers et à tout autre instant de son

histoire. Cette hypothèse est non triviale et surtout, non démontrée. C'est

d'ailleurs une conséquence directe du fameux principe d'équivalence d'Einstein.

Sans même changer les lois, différents paramètres peuvent néanmoins évoluer et

changer.

Ainsi,

de nombreuses expériences ont été menées pour mesurer l'ordre de grandeur d'une

éventuelle variation au cours du temps de la constante universelle de la

gravitation ou bien de la constante de structure fine. Plusieurs modèles

théoriques, comme la théorie des cordes, tiennent compte de ces possibles

variations sur de grandes échelles de temps.

Ce

qu'il faut retenir est que les lois de la physique à l'échelle subatomique sont

essentielles, bien que non suffisantes, à la construction d'un modèle

cosmologique cohérent : leur universalité reste néanmoins un postulat, pratique

certes, mais discutable.

Outre

ces deux postulats de départ, le modèle standard cosmologique s'est construit

autour de quatre

hypothèses principales :

La première est la théorie de la relativité générale,

donnant une explication cohérente aux phénomènes gravitationnels que l'on

observe et dont les prédictions sont en extraordinaire accord avec les mesures

effectuées (sauf dans le cas particulier des courbes de rotation des galaxies,

voir ci-après). Toutefois, il existe aujourd'hui de nombreuses théories qui,

bien que profondément différentes de la relativité générale, aboutissent aux

mêmes prédictions mais diffèrent lorsqu'il s'agit de décrire les débuts de

l'Univers. Car le problème est bien là : le modèle standard utilise deux

théories aux fondements incompatibles, la théorie de la relativité générale pour

la géométrie à « grande échelle » de l’espace-temps et la physique quantique

pour le comportement microscopique du contenu de cet espace-temps.

C’est

un affrontement direct entre une physique du « continu » dans laquelle

l’espace-temps est conçu comme une surface

(ou

variété) lisse et une physique du « discontinu » où l’espace-temps a une

structure que l’on pourrait qualifier de « granulaire », voire indescriptible

en-dessous de la longueur de Planck (environ 10-33 cm) qui représente

en quelque sorte la taille des plus petits grains décrits par nos théories

physiques. Et le problème devient insurmontable lorsque l’on se rapproche de

l’instant zéro de la création de l’Univers, car aucune des deux théories n’est

suffisante pour décrire le comportement de l’Univers au voisinage du Big Bang.

Leurs domaines respectifs de validité sont tout simplement dépassés et le

physicien a besoin d’autres outils pour comprendre.

La deuxième est la description qui est faite de la matière par les lois

physiques. Par

exemple, les courbes de vitesses de rotation des galaxies, la dynamique des

galaxies au sein des amas ou encore les grandes structures, ne sont explicables,

via la relativité générale, que grâce à l'introduction de la matière noire. De

même, l'expansion accélérée de l'Univers ne peut être comprise, dans le modèle

standard, qu'en supposant une constante cosmologique non nulle, c'est-à-dire en

postulant l'existence d'une énergie sombre (ou noire) qui représente environ 70%

du contenu total en énergie de l'Univers. L'introduction de ces paramètres

cosmologiques a évidemment une influence directe sur un autre modèle standard

qui est celui des particules : quelle est la nature de cette matière noire et de

cette énergie sombre ? Faut-il découvrir de nouvelles particules ? Ces questions

marquent encore le lien profond qui existe entre la physique de l'infiniment

grand et celle de l'infiniment petit.

La troisième hypothèse invoque des propriétés de symétrie de l'espace-temps

permettant de résoudre les équations d'Einstein de la relativité générale. Elle

est le reflet de l'isotropie observée en ce qui concerne, par exemple, le fond

diffus cosmologique ou bien la distribution des galaxies sur de grandes

échelles. Cela se traduit par une réduction drastique du nombre des possibilités

quant à la détermination de la métrique universelle. En fait, il n'y a plus que

deux possibilités : soit notre Univers est à symétrie sphérique et nous sommes

situés proche de son centre, soit il est spatialement isotrope en chacun de ses

points, ce que l'on traduit également par l'Univers est homogène et spatialement

isotrope. Cette seconde possibilité constitue ce que l'on appelle le principe

cosmologique. A défaut de pouvoir trancher via des observations, c'est celle-ci

qui est retenue comme postulat en supposant que nous n'avons aucune raison

d'être des observateurs ayant une place privilégiée dans l'Univers, autrement

dit, en invoquant le principe de Copernic. Cela conduit à une métrique dite de

Friedmann-Lemaître (appelée aussi métrique de

Friedmann-Robertson-Walker-Lemaître) qui nous dit que localement les tranches

d'espace sont homogènes et isotropes et que leur géométrie ne peut être que de

trois types différents, à savoir, sphérique, euclidienne ou hyperbolique.

La quatrième et dernière hypothèse, enfin, concerne la structure globale de

l'Univers dont

l'unicité n'est aucunement nécessaire pour garantir la géométrie localement

observée. Par exemple, un cylindre a la même métrique ou la même géométrie qu'un

plan, mais sa topologie, ou sa forme, est différente. Le problème est qu'il est

très difficile, voire impossible, de déterminer, grâce à des observations, la

forme de l'Univers, surtout lorsque celui-ci a une taille qui dépasse le rayon

de Hubble (défini comme le rapport c/H, où c est la vitesse de la lumière dans

le vide et H la constante de Hubble actuelle).

Revenons à présent sur la construction historique du modèle standard ou théorie

du Big-Bang des origines, datant du début du siècle dernier, à nos jours.

Nous

avons vu le rôle central de la relativité générale dans l'élaboration d'un

modèle cosmologique : il n'est pas étonnant dès lors que l'un des premiers à

s'être intéressés à l'évolution de l'Univers est

Albert Einstein.

En 1917, il imagine un Univers statique dont la topologie spatiale est celle

d'une sphère, et cela, grâce à l'introduction d'une constante cosmologique ad

hoc dont on ne savait alors pas trop quoi penser.

Dans

les années 1920, ce sont

Alexandre Friedmann (1888-1925) et

Georges Lemaître

(1894-1966) qui développent indépendamment des solutions plus générales aux

équations d'Einstein tout en montrant qu'elles impliquent que l'Univers est en

expansion.

Lemaître fut le premier à prédire que cette expansion doit produire un décalage

vers le rouge des raies spectrales produites par des objets lointains, le fameux

redshift cosmologique. Il faut savoir qu'à cette époque, la distance des

galaxies n'avait pas été déterminée et que celles-ci étaient classées comme des

nébuleuses faisant partie de la Voie Lactée.

Mais,

en 1929, les observations

d'Edwin Hubble

confirment la prédiction de Lemaître tout en montrant que la Voie Lactée n'est

pas la seule galaxie dans l'Univers ! L'Univers est désormais en expansion et

son taux d'expansion, la constante de Hubble, peut être mesurée.

Mais

les travaux de Lemaître et Friedmann, lorsque l'on remonte dans le passé,

impliquent également que l'Univers a connu une phase de son existence pendant

laquelle la densité et la température devaient être incroyablement élevées :

Lemaître appela cette idée la théorie de

l'atome primitif.

C'était, bien sûr, l'ancêtre de ce qui allait devenir la théorie du Big Bang.

Cette

théorie naissante allait pourtant connaître un certain nombre de détracteurs

parmi lesquels le plus célèbre est sans conteste

Fred Hoyle

(1915-2001) avec sa théorie de l'état stationnaire. Paradoxalement, c'est ce

même détracteur qui, lors d'une émission radio sur la BBC en mars 1948, qualifia

de Big Bang ce que la théorie de l'expansion nous apprenait de la naissance de

l'Univers. La notoriété de la théorie du BigBang était désormais inscrite dans

les esprits.

C'est

alors qu'entrent en scène les physiciens

Ralph Alpher, Hans Bethe

et George Gamow qui, dans un célèbre article de 1948, évoquent pour la

première fois le problème de la nucléosynthèse primordiale c'est-à-dire la

formation des premiers noyaux atomiques dans l'histoire de l'Univers. La même

année, avec Robert Herman, Alpher prédit même l'existence et la

température (2,7 K) du

fond diffus cosmologique, rayonnement émis au moment où l'Univers est

devenu transparent au rayonnement électromagnétique, environ 380000 ans après le

Big Bang.

La

confirmation observationnelle de ce fond diffus cosmologique attendra 1964 et la

découverte fortuite des radio-astronomes

Arno Penzias et Robert

Wilson. Face à ce succès, les opposants à la théorie du Big Bang allaient

alors être beaucoup moins nombreux...

Mais

en cette fin des années quarante, la théorie du Big Bang connue également un

important développement théorique initié par

Evgeny Lifshitz

(1915-1985), ancien élève et collaborateur du célèbre

Lev Landau.

À

partir des équations d'Einstein, il étudia comment de faibles perturbations de

densité, dans les premiers instants de l'Univers, pouvaient conduire aux grandes

structures que l'on observe aujourd'hui (amas de galaxies, superamas, filaments

et grands espaces vides).

Ces

travaux sont à l'origine d'un élément essentiel du modèle standard actuel, à

savoir, la théorie de

l'inflation, dont les arguments utilisent à la fois la physique quantique

et la relativité générale et dont les conséquences peuvent être mesurées – par

exemple – dans l'anisotropie de la température du fond diffus cosmologique.

Rappelons que la théorie de l'inflation est apparue à la fin des années

soixante-dix avec les travaux de

François Englert, Robert

Brout et Edgard Gunzig, puis ceux

d'Alexei Stavrobinsky

ou encore d'Alan Guth

à partir de 1981.

L'inflation est une phase d'expansion accélérée de l'Univers primordial, lorsque

celui-ci était proche d'un espace dit de de Sitter, qui se serait produite juste

avant la phase de domination du rayonnement.

Elle

marque la fin de la période dite de Grande Unification et les débuts d'une

nouvelle force, l'interaction forte.

L'Univers change littéralement d'état (comme lorsque de l'eau se transforme en

glace...): on appelle cela une

transition de phase.

Associée à une brisure de symétrie, la libération d'énergie est simplement

colossale. L'inflation fait intervenir un nouveau champ scalaire, appelé

inflaton, qui est à l'origine de l'accélération prodigieuse de l'expansion de

l'Univers.

C'est

au cours de cette expansion que les fluctuations quantiques ont été amplifiées

jusqu'à permettre la formation des grandes structures. En seulement 10-32s,

la taille de l'Univers a augmenté d'un facteur de plus de 10⁵⁰.

À titre de comparaison, la taille de l'Univers de la période qui a suivi

l'inflation jusqu'à aujourd'hui n'a varié que d'un facteur mille.

Cette

théorie a fourni pour la première fois une explication cohérente des premiers

instants de l'Univers que la théorie initiale n'était pas en mesure de décrire.

Elle apporte une solution à deux problèmes principaux qui ne sont rien d'autre

que des conséquences des équations de la relativité générale. Il y a tout

d'abord le problème dit de la platitude qui veut que l'Univers ait quasiment ou

exactement la densité requise pour avoir une courbure nulle. Schématiquement,

pendant l'inflation, la courbure de l'Univers s'annule très rapidement.

Puis,

il y a le problème de l'horizon qui soulève le paradoxe de l'homogénéité d'un

Univers constitué de zones causalement déconnectées remplies d'un même fond

diffus cosmologique.

Enfin,

l'inflation sert aussi de point d'ancrage à la théorie

des multivers ou

univers bulles (Andreï

Linde, célèbre chercheur russe, emploie même le terme de mousse

d'univers) créés de façon continue par des processus inflationnaires sans début

ni fin...

Ce qui

est sûr, c'est que l'amélioration des techniques de détection des ondes

gravitationnelles et les nouveaux projets instrumentaux, qui verront le jour

dans les prochaines années, font que l'inflation pourra bientôt être soumise à

de nouveaux tests observationnels : l'idée sera en effet la détection directe ou

indirecte d'un spectre unique d'ondes gravitationnelles produites durant la

phase inflationnaire et présentes dans tout l'Univers.

En résumé, le modèle cosmologique standard actuel semble ne pas

pouvoir se passer d'une

phase inflationnaire précédent ce que l'on appelle la phase chaude du Big

Bang (voir encadré).

Il intègre la notion

de matière noire et

d'énergie sombre en supposant une constante cosmologique non nulle, notée

traditionnellement L.

Sa formulation date de 1995 et elle est due à

Jeremy Ostriker et Paul

Steinhardt : on parle alors de modèle CDM (CDM pour Cold Dark Matter). Il

est corroboré par trois observations principales que sont :

l'homogénéité du fond diffus

cosmologique,

l'abondance relative des différents

éléments chimiques présents dans l'Univers et,

bien sûr, l'expansion de l'Univers.

Dans ce modèle, l'histoire de l'Univers post-inflationnaire peut

se scinder en trois phases d'expansion, distinctes d'un point de vue

thermodynamique :

une première phase pendant laquelle

l'Univers est dominé par

l'énergie du rayonnement,

une deuxième dominée par l'énergie

associée à la matière

baryonique et

enfin, une troisième, celle dans

laquelle nous sommes, dominée par

l'énergie sombre.

En 1998, une autre observation, que l'on peut qualifier

d'historique, et concernant les

supernovæ de type Ia

marqua un tournant important dans la cosmologie moderne et conforta ce modèle.

Les supernovæ de ce type sont couramment utilisées comme étalon de distance :

or, il s'est avéré que les plus éloignées d'entre elles étaient moins lumineuses

et situées à une distance plus grande que ce qui était prévu par la théorie. La

seule explication plausible dans le cadre du modèle standard fut que l'Univers

est en expansion

accélérée depuis plusieurs milliards d'années ! Cette observation appuie

donc aujourd'hui l'idée d'une constante cosmologique non nulle et d'une énergie

sombre dominante agissant comme une force répulsive à l'échelle de l'Univers.

Comme nous l'avons vu, un modèle cosmologique se doit d'expliquer

les observations que l'on peut faire aujourd'hui de notre Univers, tout en

proposant un scénario historique plausible et, évidemment, tout en se rattachant

aux connaissances physiques que l'on a du contenu de l'Univers.

Nous allons essayer à présent de voir quelles sont ces

observations et, surtout, quelles sont leurs limite

Les observations astronomiques ont ceci de particulier que les

informations que l'on perçoit des objets que l'on veut étudier sont toujours

relatives au passé de ces derniers: en d'autres termes, la finitude de la

vitesse de la lumière fait que, selon la formule consacrée, plus on regarde

loin, plus on regarde tôt dans le passé. Il est équivalent de dire que les

seules informations sur le passé lointain de l'Univers sont fournies par des

objets spatialement très éloignés de notre position actuelle.

Si l'on a pris conscience des échelles de distances cosmologiques

uniquement à partir des années 1920-1930, une vraie avancée, dans les

observations, a eu lieu dans les années soixante lorsque de nombreux

instruments, équipés de technologies nouvelles, ont permis peu à peu de sonder

l'Univers dans toutes les gammes de fréquence du spectre électromagnétique

allant du domaine radio au rayonnement gamma.

De nos jours, le nombre de données observationnelles est

d'ailleurs tel que les scientifiques ont souvent du mal à analyser et à

interpréter tout ce que leurs instruments ont enregistré. L'avantage est que les

modèles théoriques peuvent plus rapidement qu'auparavant être mis à l'épreuve

des observations et, le cas échéant, être mis en défaut.

Mais quelles sont les

principales observations ?

1 -

L'isotropie - Tout

d'abord, ce qui est frappant est que, quelle que soit la direction dans laquelle

on regarde l'Univers, la distribution spatiale et la nature des objets qu'il

contient semblent être les mêmes. Cette isotropie se retrouve, comme nous

l'avons déjà évoqué, dans le fond diffus cosmologique dont les variations

relatives de température sont inférieures à 10-4 . Ce fait constitue

un argument solide quant à l'hypothèse d'un Univers homogène et isotrope aux

échelles cosmologiques et donc à l'utilisation de la métrique de

Friedmann-Lemaître.

2

– L'abondance relative des

éléments chimiques (voir aussi l'encadré) : la nucléosynthèse primordiale

est la synthèse des éléments chimiques qui a suivi la période inflationnaire.

C'est un des arguments les plus forts appuyant la théorie du Big Bang. Elle

commence entre 1 et 2 secondes après le Big Bang lorsque la température de

l'Univers descend en-dessous du MeV et elle ne devient vraiment efficace qu'à

partir de la troisième seconde. Le deutérium, constitué d'un proton et d'un

neutron se forme très tôt, mais cet isotope de l'hydrogène est également

rapidement détruit après la nucléosynthèse primordiale : c'est pour cette raison

que la détermination de son abondance requiert d'observer des nuages de matière

possédant des redshifts élevés tout en étant sur la même ligne de visée que des

quasars encore plus lointains dont ils absorbent la lumière. Bien que difficile,

ces observations ont conduit à une détermination précise de son abondance

primitive relative qui s'élève à 10-5 (autrement dit, il y a 105

plus d'hydrogène que de deutérium dans l'Univers primordial). Un autre élément,

l'hélium 4 est lui beaucoup plus abondant. Comme sa production a continué tout

au long de l'histoire de l'Univers, essentiellement au sein des étoiles

lorsqu'elles sont dans la séquence principale, son abondance primitive, égale à

environ 25 %, a été déduite d'observations de régions dite HII, c'est-à-dire

constituées principalement par de l'hydrogène ionisé, qui sont situées dans des

galaxies bleues compactes. L'abondance du lithium primitif est quant à elle

déduite d'observations d'étoiles ayant une faible métallicité et situées en

périphérie de notre Galaxie, dans son halo. La raison est la suivante ; on

suppose simplement que leur surface n'est pas polluée par du lithium produit par

d'autres étoiles ayant évoluées en supernovæ. Cependant, les résultats semblent

montrer un désaccord manifeste entre l'abondance mesurée et celle prédite par le

modèle théorique de la nucléosynthèse primordiale suite aux observations du fond

diffus cosmologique. Il n'existe actuellement aucune solution à la différence

observée et cela reste donc un problème inexpliqué dans le modèle standard qui

est désormais connus sous le nom de problème du lithium.

3 -

Les distances et les âges

des objets : pour une étoile relativement proche – par exemple - la

distance peut facilement être évaluée directement par la méthode de la

parallaxe. En revanche, cette méthode ne fonctionne plus dès que les objets sont

situés plus loin, typiquement au-delà de 200 années-lumière : on dispose alors

d'un certain nombre d'étalons qui permettent de déduire la distance de façon

indirecte. On peut citer les étoiles variables céphéides, les supernovae de type

Ia ou les supergéantes rouges les plus brillantes. Ces mesures sont parfois

appuyées par des relations du type distance-luminosité pour des amas globulaires

ou des nébuleuses planétaires ou bien, on utilise des relations du type

Tully-Fisher pour certaines galaxies. Le problème dans cette démarche est que

les objets lointains sont difficilement observables en ce sens que leur lumière,

en traversant le milieu intergalactique, peut-être plus ou moins absorbée, ou

encore déviée par des effets de lentilles gravitationnelles, ce qui fausse

l'estimation de leur distance. Même l'émission intrinsèque de ces objets peut

être anisotrope ce qui signifie que deux objets identiques situés au même

endroit peuvent avoir des luminosités complètement différentes suivant l'angle

sous lequel on les observe, et même, ils peuvent très bien ne pas présenter le

même spectre électromagnétique. Le redshift est également un indicateur de

distance, mais il est difficile de distinguer ce qui est dû à un mouvement

intrinsèque de l'objet observé (redshift cinématique) et ce qui est dû à son

éloignement (redshift cosmologique). Il reste que l'importance de la mesure des

distances est cruciale notamment pour déterminer la constante de Hubble,

c'est-à-dire le taux d'expansion actuel de l'Univers. Cette constante permet

d'estimer la taille de l'Univers observable ainsi que son âge. Elle est donc

tout à fait cruciale dans le modèle cosmologique standard. L'âge de l'Univers

que l'on obtient aujourd'hui (13,8 milliards d'années) fournit ainsi une limite

haute de l'âge des objets que l'on peut voir dans l'Univers. L'observation de

certains objets lointains (ayant des redshifts élevés) a pu confirmer que leur

âge était bien inférieur à celui de l'Univers, même si certains objets ont pu

faire l'objet de controverses comme – par exemple – le quasar APM 08279+5255 ou,

plus récemment, certaines galaxies très lointaines.

4

– L'accélération de

l'expansion de l'Univers : Nous avons vu que l'observation des courbes de

lumière de supernovæ de type Ia dans des galaxies lointaines font d'elles ce que

l'on appelle des chandelles standards. Plus précisément, la corrélation qui

existe entre leur pic de luminosité et la décroissance de leur courbe de lumière

permet de déterminer leur distance. De façon inattendue, cela a permis de

montrer que l'Univers est en expansion accélérée et que cela implique dans le

modèle standard que la constante cosmologique est non nulle et voisine de 0,7.

Même si la nature de cette accélération n'est pas encore claire, il semble

qu'elle concerne les objets jusqu'à des redshifts de l'ordre de 0,33 : autrement

dit, l'expansion de l'Univers s'accélère, mais seulement depuis quelques

milliards d'années. L'hypothèse qui semble le mieux s'adapter aux observations

est celle d'un champ scalaire de nature inconnue ayant une pression effective

négative : ce champ a été appelée énergie sombre ou noire et contient (comme

l'indique la valeur 0,7 de la constante cosmologique) près de 70% (69,2% d'après

les mesures les plus récentes) de l'énergie totale de l'Univers. La

détermination de sa nature est fondamentale aussi bien pour le modèle standard

cosmologique que pour la physique des particules.

5 –

La cinématique de la matière

visible : les galaxies semblent toutes regroupées en amas et superamas

donnant l'impression de vastes murs, mais aussi de grands vides intergalactiques

qui sont des zones immenses presque dépourvues de galaxies. C'est le mouvement

des galaxies à l'intérieur même d'un amas ainsi que le mouvement des étoiles en

périphérie d'une galaxie donnée qui montrent le mieux que les caractéristiques

du champ gravitationnel ne sont pas celles que l'on attendrait si l'on ne

considérait que la matière visible. Ainsi – par exemple – on observe que les

étoiles conservent des vitesses orbitales bien trop élevées lorsque l'on

s'éloigne du centre galactique et même de la partie visible de la galaxie qui

les abrite. Cela ne peut se produire que si la quantité de matière à l'intérieur

de l'orbite de ces étoiles continue de croître lorsque l'on s'éloigne du centre.

C'est de ces observations qu'est née la nécessité d'introduire de la matière

noire entourant chaque galaxie et modifiant, par conséquent, toutes les

interactions gravitationnelles (voir l'encadré). La quantité de matière noire

est loin d'être négligeable puisqu'elle dépasse de loin celle de la matière

visible : en termes d'énergie, et d'après les derniers résultats de la mission

Planck, elle représente près de 26% de l'énergie totale de l'Univers alors que

la proportion de matière ordinaire plafonne juste en-dessous des 5%.

6 –

Le fond diffus cosmologique

: cette émission électromagnétique perçue aujourd'hui dans le domaine des

micro-ondes a été émise lorsque l'Univers devint brusquement transparent

c'est-à-dire lorsque la matière et le rayonnement se sont découplés. Il n'était

alors âgé que de 380000 ans environ et sa température était voisine des 4000 K.

Son spectre, identique à celui d'un corps noir, n'est que le reflet de

l'équilibre entre les photons et la matière qui a précédé son émission.

L'expansion de l'Univers, de plus d'un facteur 1000 depuis cette époque, a fait

qu'il s'est refroidi jusqu'à ce que le rayonnement corresponde à celui d'un

corps noir de seulement 2,75 K. Les très faibles anisotropies que l'on observe

dans son spectre aujourd'hui constituent les traces des faibles inhomogénéités

qui existaient dans l'Univers primordial et qui sont à l'origine des grandes

structures. De même, l'étude de la polarisation du fond diffus cosmologique

donne non seulement des indications précises sur les ondes gravitationnelles

émises dans la période inflationnaire, mais elle permet aussi de déterminer

l'âge du début de la période de réionisation - ou âge d'apparition des premières

générations d'étoiles (population III) constituées uniquement des premiers

éléments légers (hydrogène, hélium et quelques traces de lithium). C'est ainsi

que des observations de WMAP, on a pu déduire que cette période, qui marque

également la fin de la période dite des âges sombres de l'Univers, a commencé

autour du redshift z=17, c'est-à-dire très tôt dans l'histoire de l'Univers.

Notons que c'est ce résultat qui a rendu peu réaliste ou peu probable les

modèles utilisant de la matière noire chaude. Ainsi, l'importance des

informations contenues dans le fond diffus cosmologique est telle que son

observation est cruciale dans la détermination des paramètres cosmologiques

utilisés dans le modèle standard qui permettent de déterminer les différentes

phases conduisant à l'Univers que l'on connaît aujourd'hui.

En

conclusion, le modèle standard cosmologique est un modèle permettant

d'expliquer relativement simplement l'ensemble des observations dont on dispose

actuellement, depuis la dynamique des galaxies jusqu'à la formation des grandes

structures en passant par l'abondance relative des différents éléments et

l'isotropie du fond diffus cosmologique.

Néanmoins, il souffre de nombreuses zones d'ombre qu'il est

absolument nécessaire d'éclaircir : parmi elles, la nature et les propriétés

physiques de ce que l'on a appelé matière noire est un point crucial qu'il faut

étudier, le problème de la constante cosmologique, ou l'introduction d'une

énergie sombre dominant complètement le contenu énergétique de l'Univers, en est

un autre.

Comme nous l'avons vu, il y a également le

problème du lithium

et de son abondance primitive qui ne semble pas correspondre aux observations.

Mais le modèle standard cosmologique souffre également des incertitudes

concernant la période inflationnaire, sa connexion avec la période chaude de

l'Univers et la naissance des grandes structures.

Plus près encore de l'instant même du Big Bang, le problème est

alors celui de la physique dans son ensemble, car il concerne les propriétés de

la matière à des échelles et à des énergies qui vont au-delà des domaines

d'application des deux principales théories physiques que l'on connaît, la

théorie quantique et la théorie de la relativité générale.

Il est alors nécessaire de faire appel à une théorie plus

générale qui engloberait ces deux théories, comme il y a un siècle la théorie de

la gravitation de Newton fût absorbée par celle d'Einstein.

Plusieurs solutions semblent exister qui ont fait l'objet

d'intenses développements théoriques ces dernières décennies : parmi elles, on

peut citer les théories des cordes et des supercordes, et la gravité quantique à

boucles, même s'il reste à définir – par exemple – comment ces théories peuvent

conduire à une phase inflationnaire dans l'histoire de l'Univers.

De plus, les tests expérimentaux permettant de conclure à leur

validité nous font encore défaut et semblent parfois impossible à imaginer !

Enfin, une autre question importante qui surgit concerne les

valeurs des constantes fondamentales que l'on rencontre en physique comme, par

exemple, la constante de structure fine ou la constante gravitationnelle, dont

il a été prouvé qu'une infime variation annihilerait toute possibilité quant à

l'émergence des systèmes physiques complexes comme ceux que l'on rencontre en

chimie et en biologie.

Additif 1

: Petite histoire de la matière noire...

Tout commence en 1933 lorsqu’un astronome suisse du nom de

Fritz Zwicky

(1898-1974) se lance dans l’étude d’un petit groupe de sept galaxies situées

dans l’amas de la constellation de la Chevelure de Bérénice, ou plus simplement,

amas de Coma. Son idée était d’étudier le comportement dynamique des galaxies en

mesurant leurs vitesses et ceci, afin d’en déduire, grâce aux lois de Newton, la

masse totale de l’amas. Une fois cette masse déterminée, il souhaitait la

comparer à celle obtenue en se basant uniquement sur la matière qui était

visible, c’est-à-dire à la quantité de lumière reçue de cet amas. On obtenait en

quelque sorte une masse dite dynamique par la première méthode et une masse dite

lumineuse dans l’autre cas.

Quelle ne fut pas sa surprise lorsqu’il constata que les vitesses

observées étaient très élevées ! Pour éviter que l’amas ne se disloque et que

les galaxies ne se séparent, il était absolument nécessaire de considérer que sa

masse dynamique était énorme, plus de 400 fois la masse lumineuse que l’on

pouvait déduire de l’observation de l’amas !

Bien que ses conclusions étaient numériquement surestimées en

raison de l’utilisation d’une constante de Hubble bien trop élevée, Zwicky

n’avait pas tort pour autant sur la réalité du phénomène et, dans une

publication de 1937, il propose même la recherche de lentilles gravitationnelles

afin de sonder certains amas de galaxies.

Le caractère excentrique de Zwicky ne joua pas en sa faveur et sa

découverte fut accueillie fraîchement par la communauté scientifique de l’époque

qui doutait encore de la stabilité gravitationnelle des amas de galaxies.

Pourtant, en 1936, Sinclair Smith fit lui aussi le même type de

mesures, mais cette fois sur l’amas de la Vierge. Il aboutit aux mêmes

conclusions ! Trois ans plus tard, en 1939, Horace Babcock entreprend, quant à

lui, de mesurer la vitesse de rotation de la galaxie d’Andromède, la plus grande

voisine de la Voie Lactée et trouve une valeur trop élevée et qualifiée d’«

anormale ». L’histoire de ce problème semble alors s’arrêter, mais pendant vingt

ans, la théorie du Big Bang s’affine et la constante de Hubble devient plus

précise.

En 1959, Kahn et Woltjer font part de leurs mesures concernant

notre amas local de galaxies : celles-ci mettent en évidence une masse manquante

pour laquelle aucune explication n’est trouvée. Parallèlement et la même année,

Louise Volders observe que la vitesse de rotation des étoiles au sein de la

galaxie voisine M33 ne diminue pas avec la distance comme le prévoit les lois de

Newton et en supposant que toute la matière est concentrée dans les zones qui

émettent de la lumière.

L’idée de matière noire, ou sombre, commençait à intéresser un

nombre croissant de scientifiques. Citons les travaux de

Vera Rubin sur

les vitesses de rotation dans la galaxie d’Andromède, ou encore ceux de Ostriker

et Peebles qui démontrèrent dès 1973 que les disques galactiques sont instables

en l'absence d'un halo étendu de matière noire.

Qu’en est-il aujourd’hui ? Cette matière noire n’a toujours pas

été directement observée. Néanmoins, elle semblerait représenter plus de 90% de

la masse des galaxies et entourerait chaque galaxie d’un immense halo de forme

sphérique, seule configuration possible pour expliquer la stabilité des

structures visibles.

Récemment, il a même été observé une galaxie, nommée Dragonfly

44, dont la masse, comparable à celle de la Voie Lactée, est composée de 99,99%

de matière noire ! De nombreuses hypothèses ont été formulées quant à la nature

de cette matière noire, mais aucune n’a trouvé de preuves suffisantes. La

première hypothèse serait de considérer que la matière noire est composée de

tous les objets trop peu lumineux pour être observés avec nos instruments à

savoir, les naines brunes, les naines blanches, les étoiles à neutrons et les

trous noirs isolés.

Cette hypothèse semble fragile : en effet, le nombre de ces

objets invisibles devrait être beaucoup trop élevé. D’autres ont même suggéré

d’abandonner l’idée de la matière noire et de considérer plutôt une modification

de la loi de Newton à grande distance, mais sans succès…

La solution se trouve peut-être du côté de la physique des

particules.

Plusieurs indices observationnels récents ont montré que la

matière noire semble interagir très peu (en dehors de l'interaction

gravitationnelle), voire pas du tout, avec la matière baryonique ordinaire

(protons, neutrons).

Elle serait donc de nature différente, c'est-à-dire

non-baryonique. Aussi, il existe de nombreux modèles de matière noire que l'on

qualifiera tantôt de chaude, froide, tiède, floue, répulsive, annihilante,

instable ou encore, en auto-interaction forte...

Parmi ceux-ci, on peut citer deux principales théories : l’une

fait appel à de la matière noire dite chaude, c’est-à-dire à des particules

légères et relativistes (c'est-à-dire dont la vitesse est proche de celle de la

lumière). On pense alors bien évidemment aux neutrinos, particules

insaisissables ou presque, mais ces derniers ne semblent pas conduire à une

solution cosmologique satisfaisante.

L’autre théorie considère de la matière noire dite froide

c’est-à-dire composée de particules plus massives et plus lentes. Les candidats

hypothétiques les plus célèbres composant la matière noire froide sont les

WIMPs, signifiant Weakly Interacting Massive Particles, nom générique donné à

des particules issues des théories supersymétriques, mais aucune détection

directe n’a été effectuée à ce jour !

Ces deux théories se distinguent notamment dans ce qu’elles

impliquent dans l’histoire de l’Univers et, plus particulièrement, dans la

formation des grandes structures comme les amas et les superamas de galaxies peu

de temps après le Big Bang et sa phase inflationnaire.

La matière noire chaude conduit à la formation d’amas de galaxies

par fragmentation de superamas tandis que la matière noire froide favorise

plutôt, dans l’ordre, la formation de galaxies, puis d’amas et enfin de

superamas, et c'est ce dernier scénario que semble confirmer les données

récentes fournies par WMAP.

Il reste que la cosmologie d'aujourd'hui fournit des contraintes

observationnelles remarquables pour le modèle standard des particules, et que la

course pour déterminer la nature de la matière noire se joue également dans les

laboratoires.

Additif

2 : Zoom sur la période chaude du Big Bang

Dans le modèle standard cosmologique, cette période débute à la

fin de l'inflation sans que l'on connaisse vraiment les mécanismes de transition

entre ces deux phases distinctes. La température de l'Univers est alors

supérieure à 100 MeV (soit 1012 K), ce qui implique qu'il est

entièrement dominé, sur le plan énergétique, par des particules relativistes à

l'équilibre comme les électrons, les positrons, les neutrinos et bien sûr, les

photons. Les protons et les neutrons n'ont alors qu'un rôle négligeable.

Lorsqu'au bout de quelques secondes l'Univers s'est suffisamment

refroidi (T<1 MeV soit 1010

K) les premiers noyaux atomiques de deutérium, d'hélium et de lithium se forment

à partir des nucléons (protons et neutrons).

Les neutrinos se découplent tandis les neutrons libres

(instables) se transforment en protons.

Mais la température est encore bien trop haute pour que des

atomes puissent de former : les photons, les électrons et les noyaux atomiques

légers sont donc en équilibre thermodynamique.

Les électrons interagissent fortement avec les photons via des

processus de diffusion Compton ce qui rend l'Univers complètement opaque aux

photons.

Au bout de 380.000 ans - ce qui correspond à une redshift

d'environ 1100 - l'expansion de l'Univers a fait baisser sa température

suffisamment (environ 4000 K) pour que les noyaux atomiques capturent des

électrons, c'est-à-dire pour que des

atomes se

forment.

Les interactions photons-électrons libres disparaissent alors, ce

qui a pour conséquence de rendre l'Univers transparent aux photons.

Ces premiers photons, libérés de toute interaction, ont un

spectre énergétique identique à celui d'un corps noir qui aurait la même

température que l'Univers.

C'est ce qui marque la naissance du fond diffus cosmologique que

l'on observe aujourd'hui et qui est constitué de ces photons que l'expansion de

l'Univers a refroidi au cours des presque 14 milliards d'années qui ont suivi

cette période.

C'est également à ce moment-là que la transition s'opère entre un

Univers dominé par le rayonnement et un Univers dominé par la matière.

Denis Gialis.

LES

EXOPLANÈTES : GLIESE 436b NE TOURNE VRAIMENT PAS ROND !

(02/01/2018)

On se souvient peut être qu’en 2004, c’est l’équipe de Butler et

Marcy qui avait découvert une planète tournant autour de l’étoile Gliese 436

(naine rouge). C’était une petite géante gazeuse (mini Neptune) avec une orbite

elliptique, ce qui était bizarre pour une planète aussi proche de son étoile.

En 2005, on découvre qu’elle est entourée d’un nuage d’Hydrogène,

bref qu’elle semble « s’évaporer », son atmosphère est progressivement

« soufflée » par les puissants rayonnements UV et X de son étoile hôte.

De plus elle est très près de son étoile (4 millions de km,

période 2,6 jours)

Mais les études de cette bizarre planète ont continué grâce à nos

amis de l’Université et de l’Observatoire de Genève, l’UNIGE.

Illustration : vue polaire de Gliese 436b. NASA/ESA.

En effet, une équipe internationale composée de scientifiques

français et suisses, et menée par des chercheurs de UNIGE, ont mis au jour

une orbite polaire

de cette planète. Ce qui est contraire à la normale, généralement les planètes

(issues de la formation d’un disque planétaire) tournent approximativement dans

le plan équatorial de l’étoile et dans le sens de rotation de celle-ci.

Le système de Gliese 436 est totalement irrationnel !

Tout ceci a fait l’objet d’un article dans

la revue Nature

dans la revue

Astronomy

and Astrophysics et d’un

communiqué de presse de l’UNIGE que voici :

Des astronomes de

l’Université de Genève (UNIGE) membres du Pôle National de Recherche PlanetS, en

collaboration avec les universités de Berne, Warwick, Grenoble Alpes et

l’Institut d’astrophysique de Paris, ont braqué le télescope spatial Hubble sur

une exoplanète qui avait déjà été observée perdant son atmosphère. Celle-ci

forme un immense nuage d’hydrogène, donnant à la planète l’aspect d’une comète

géante. Cependant, les précédentes observations, datant de 2015, n’avaient pu

couvrir l’ensemble du nuage, dont la forme avait été prédite par des simulations

numériques. Grâce à de nouvelles observations, les chercheurs viennent enfin de

confirmer leur prédiction.

Les résultats sont à lire

dans la revue Astronomy & Astrophysics.

L’exoplanète GJ 436b, d’une

taille semblable à Neptune (soit environ quatre fois la Terre), révèle une

immense chevelure de gaz lorsqu’on la regarde à travers des lunettes

ultraviolettes. Ce phénomène, découvert en 2015 par des astronomes de

l’Observatoire de la Faculté des sciences de l’UNIGE, serait dû à la proximité

entre la planète et son étoile, dont elle fait le tour en moins de trois jours.

En raison de l’irradiation

intense à laquelle elle est soumise,

la planète perd une

partie de son atmosphère d’hydrogène. Cette atmosphère perdue forme un

énorme nuage de gaz autour de la planète et absorbe le rayonnement ultraviolet

de l’étoile.

C’est pourquoi le nuage

n’est visible qu’avec l’œil sensible aux ultraviolets du télescope spatial

Hubble.

«Nous avons été surpris par

ce phénomène, d’une telle ampleur que nos premières observations n’avaient pu

couvrir l’ensemble du nuage lors de son passage devant l’étoile», révèle David

Ehrenreich, professeur associé à l’UNIGE et responsable du projet européen FOUR

ACES, à l’origine de cette étude. Aussi, l’équipe avait-elle extrapolé les

données collectées à l’aide d’un modèle numérique afin de prédire quelle devait

être la forme exacte du nuage. Le résultat des simulations montrait la planète

entourée d’une chevelure semblable à celle d’une comète, se prolongeant sur des

dizaines de millions de kilomètres.

L’équipe dirigée par

Baptiste Lavie, doctorant PlanetS à l’UNIGE, a pointé à nouveau Hubble sur GJ

436b.

Et les résultats confirment

en tous points les prédictions des chercheurs : «Je me faisais des cheveux

blancs à l’idée d’analyser ces nouvelles observations», indique Baptiste Lavie.

«C’est donc une grande satisfaction de voir que le panache d’hydrogène

s’échappant de la planète est bien là, conforme aux prédictions, car nous

comprenons à présent comment il se forme», souffle-t-il.

En effet, les données

injectés dans le modèle numérique expliquent correctement les observations :

«Nous avons même pris en compte la pression que la lumière de l’étoile exerce

sur les atomes d’hydrogène qui s’échappent de la planète !» précise Vincent

Bourrier, astronome à l’UNIGE, qui a développé le modèle numérique.

La résolution de l’énigme

posée par ce phénomène exceptionnel va maintenant permettre aux chercheurs de

comprendre comment il affecte d’autres exoplanètes, certaines encore plus

irradiées que GJ 436b.

«Nous nous attendons maintenant à de

nouvelles surprises», sourit Baptiste Lavie. »

On espère donc en savoir plus sur le système planétaire éventuel

de Gliese 436.

Cette inclinaison orbitale aussi anormale est peut être le signe

de la présence d’une autre planète massive, style Jupiter, située plus loin.

La chasse continue donc !

Une

vidéo explicative :

POUR ALLER PLUS LOIN :

L’exoplanète qui ne tournait pas

rond, article de l’INSU.

Une exoplanète «chevelue» orbite de façon étrange autour de son étoile,

article du Figaro.

C'est sûr : la planète chevelue existe !

de Sciences et avenir.

Orbital misalignment of

the Neptune-mass exoplanet GJ 436b with the spin of its cool star article de

Nature

Hubble sees atmosphere

being stripped from Neptune-sized exoplanet

BIZARRE : UNE ÉTOILE QUI NE VOULAIT PAS MOURIR !

(02/01/2018)

Il y a des supernovæ qui sont bizarres, comme par exemple

iPTF14hls (acronyme de Intermediate Palomar Transient Factory) ; celle-ci est

déjà inhabituelle car elle est de type II-P (P pour plateau, car sa courbe de

luminosité présente un plateau), les autres

type II, sont à priori de type II-L. Elle a été découverte en 2014, et sa

particularité est que sa

courbe de lumière s’est prolongée sur plus de 600 jours, alors que

normalement en max 2 à 3 mois, il ne reste plus rien.

Les astronomes pensent que cette SN a explosé…une dizaine de fois

depuis plus de 50 ans. On a même trouvé des traces de celle-ci jusqu’‘en 1954,

date à laquelle s’était produite cette explosion.

Illustration : courbe de luminosité sur les deux dernières

années.

D’après Arcavi et al. 2017, Nature. Crédit: LCO/S. Wilkinson.

Il semble donc bien que son étoile refuse absolument de mourir et

de disparaitre.

Une SN de type II laisse généralement une étoile à neutrons ou un

Trou Noir suivant sa masse.

Cela pose un problème aux scientifiques qui n’ont pas trouvé

d’explication satisfaisante pour le moment, même si certains font appel à de

l’antimatière

produite au sein de l’étoile !!

Elle ferait partie d’une toute nouvelle sorte de SN que l’on

appelle SN à production de paires (pulsational pair instability supernova). Elle

deviendrait si chaude en son cœur que l’énergie se convertirait en matière et

antimatière.

C’est du moins la théorie

d’Andy Howell de Las Cumbres (au N de Los Angeles en Californie) que l’on

connait bien.

Dans notre cas, l’étoile aurait au moins 50 masses solaires.

On rappelle qu’une supernova de type II comme son nom ne

l’indique pas correspond à l’effondrement d’UNE étoile très massive (>10 masses

solaires) alors que le type I correspond à DEUX étoiles dont l’une absorbe

l’autre jusqu’à une certaine limite.

Bref une histoire à suivre !

Une vidéo explicative :

POUR ALLER PLUS LOIN :

L'étoile qui ne veut pas mourir ! Article de Sciences et Avenir.

Antimatière : l'étoile qui ne voulait pas mourir de Futura Sciences

Energetic eruptions leading to a

peculiar hydrogen-rich explosion of a massive star, article original de

Nature

Las Cumbres Astronomers Discover a Star That Would Not Die

JUNO :.DES DÉTAILS SUR LA

GRANDE TACHE ROUGE.

(02/01/2018)

En juillet dernier (2017) la sonde Juno a survolé pour la

première fois de près la grande tache rouge de Jupiter.

On devait répondre à certaines questions comme : jusqu’à quelle

profondeur s’étend-elle ? 300km comme on le pense ?

Une telle analyse ne pouvait se faire qu’avec un instrument

dédié, le MWR (Juno's

Microwave Radiometer) le radiomètre en micro-ondes.

Il est capable de percer l’épaisseur des nuages et de faire une

analyse par « tranches » de cet ouragan.

La grande tache rouge est un ovale de couleur orange/rouge de

l’hémisphère Sud de Jupiter, il tourne dans le sens contraire des aiguilles

d’une montre (CCW) et fait approx 16.000km de large. Il a été observé depuis que

les lunettes astronomiques existent (Galilée).

Juno a découvert que cette tache a des racines plus profondes que

100 fois la profondeur des océans terrestres et qu’elle plus chaude à sa base

qu’à son sommet.

Ce sont ces variations de températures qui rendent compte des

violents vents vus à la surface.

Photo : Juno/NASA/JPL/SwRI

Clic sur la photo pour avoir l’animation gif

Depuis que l’on étudie cette tache, il semble qu’elle diminue

progressivement en taille, nous l’avions évoqué

dans ces colonnes.

Juno a aussi détecté une

nouvelle région de

radiations, juste au-dessus de l’atmosphère de Jupiter, près de l’équateur.

Cette zone contient des ions H, O et S très énergétiques se

déplaçant à une vitesse proche de celle de la lumière.

Les scientifiques ont été surpris de trouver une zone de

radiations aussi proche de la planète.

Cette zone a été détectée grâce au JEDI (Jupiter Energetic

Particle Detector Instrument), rien à voir avec Star Wars, c’est un détecteur de

particules énergétiques.

On voit sur cette image les données des 6 canaux du MWR, ces

données ont été collectées pendant l’orbite intitulée périjove 7, c’est pendant

cette orbite que Juno est passé au-dessus de la grande tache rouge.

La couche supérieure est en lumière visible en provenance de la

Junocam. Les autres, plus on pénètre plus la longueur d’onde des micro-ondes est

courte.

Crédit : NASA/JPL-Caltech/SwRI

Une

vidéo explicative :

POUR ALLER PLUS LOIN :

NASA's Juno Probes the Depths of Jupiter's Great Red Spot, article de la

NASA

https://www.jpl.nasa.gov/spaceimages/details.php?id=PIA22178

Jupiter Blues

par le JPL

Les premières images de la Grande Tache rouge par Juno, article de Sciences

et Avenir.

La mission Juno à la NASA.

Le site de la mission

Juno au SwRI. Le mieux !

Dossier de

presse de la mission et du lancement.

Le site de la mission à la NASA.

GALILEO :.ARIANE 5 LANCE 4 NOUVEAUX SATELLITES (19 À

22). (02/01/2018)

Ariane

5 lance quatre nouveaux satellites Galileo

Nouveau lancement Galileo : le système sera bientôt complet,

extrait du communiqué de l’ESA :

L’Europe compte désormais quatre satellites de navigation Galileo

supplémentaires, mis en orbite par une Ariane 5. Il suffit donc d’un seul autre

lancement pour que la constellation Galileo soit complète et puisse fournir une

couverture mondiale.

Le lanceur Ariane 5, exploité par Arianespace dans le cadre d’un

contrat avec l’ESA, a quitté le port spatial de l’Europe à Kourou (Guyane

française) à 18h36 TU (19h36 heure de Paris, 15h36 heure locale), emportant les

satellites Galileo 19 à 22.

Les deux premiers ont été mis en orbite 3 heures et 36 minutes

après le décollage, les deux derniers 20 minutes plus tard. Ils pèsent chacun

715 kg.

C’est le dispositif d’éjection des satellites, placé en haut de

l’étage supérieur d’Ariane 5, qui les a largués sur leur orbite cible, à 22.922

km d’altitude.

Dans les jours qui viennent, ils seront mis à poste sur leur

orbite finale et l’Agence du GNSS européen (GSA) procèdera à une phase d’essais

de 6 mois destinée à vérifier qu’ils sont prêts à rejoindre la constellation

opérationnelle.

Illustration : les 4 satellites n° 19 à 22 montés sous la coiffe d’Ariane.

Crédit : ESA–Pierre Carril, 2017

Cette mission

porte à 22 le

nombre de satellites Galileo en orbite.

Les services initiaux ont débuté il y a près d’un an, le 15

décembre 2016.

« C’est une nouvelle grande réussite à laquelle nous venons

d’assister, avant-dernière étape de l’achèvement de la constellation » constate

Jan Wörner, Directeur général de l’ESA.

« Ce succès est aussi celui de nos partenaires industriels OHB

(DE) et SSTL (GB) pour ce qui est des satellites, de Thales-Alenia-Space (FR,

IT) et d’Airbus Defense and Space (GB, FR) pour le segment sol, ainsi que de

tous leurs sous-traitants de l’Europe entière ; l’Europe dispose en effet

désormais d’un système mondial de navigation par satellite aux performances

remarquables ».

Paul Verhoef, Directeur de la Navigation à l’ESA, ajoute : «

L’ESA est l’agent de conception et d’approvisionnement ainsi que l’ingénieur

système de Galileo pour le compte de la Commission européenne.

C’est l’Agence du GNSS européen (GSA) qui assure, depuis juillet

dernier, la supervision du fonctionnement de ce système devenu réellement

opérationnel ».

« En conséquence, la GSA a pris le contrôle des quatre satellites

dès leur séparation du lanceur, l’ESA conservant un rôle consultatif. Ce

partenariat fructueux se poursuivra lors du prochain lancement Galileo, qui sera

assuré par une Ariane 5 à la mi-2018 ».

« D’ici là, l’ESA conduira également avec la Commission

européenne et la GSA des travaux spécifiques de recherche, de développement et

de conception système en vue de l’approvisionnement de la deuxième génération de

satellites Galileo, et de l’étude d’autres technologies de navigation ».

Le lancement de l’an prochain permettra d’achever la

constellation Galileo qui

comportera en tout 24

satellites et deux unités de secours.

L’année 2017 s’est parfaitement conclue pour Ariane 5, qui améliore son propre

record grâce à ce 82e succès consécutif depuis 2003

Ariane

5 ES lancera encore quatre satellites Galileo en 2018, avant de passer le relais

à Ariane 6.

En

effet, deux Ariane 62, la version à deux boosters de la nouvelle Ariane 6

équipée du moteur ré-allumable Vinci, mettront en orbite quatre nouveaux

satellites entre fin 2020 et mi-2021. Cette décision a fait l’objet d’un

contrat, signé en septembre dernier entre Arianespace et l’ESA, pour le compte

de la Commission Européenne (DG GROW) et de l’Union européenne.

À

propos de Galileo

Galileo est le système civil de navigation par satellite à couverture mondiale

de l’Europe. Il permettra à ses utilisateurs du monde entier de connaître leur

position exacte dans le temps et l’espace de manière très précise et fiable.

Une

fois complet, le système consistera en 24 satellites opérationnels et

l’infrastructure au sol associée pour fournir des services de localisation,

navigation et synchronisation.

Le

programme Galileo appartient à l’UE, qui le finance. La Commission européenne,

en sa qualité de responsable de l’ensemble du programme, assure la gestion et la

supervision de la mise en œuvre de toutes les activités afférentes.

Le

déploiement de Galileo, la conception et le développement de systèmes de

nouvelle génération ainsi que le développement technique de l’infrastructure

sont confiés à l’ESA. Les phases de définition, de développement et de

validation en orbite (IOV) du programme Galileo ont été conduites par l’ESA et

financées conjointement par l’ESA et la Commission européenne.

La GSA

assure la promotion et la sécurité de Galileo. Depuis 2017, elle est également

responsable de l’exploitation de Galileo et de la fourniture des services

correspondants

POUR ALLER PLUS LOIN :

Nouveau lancement Galileo le système sera bientôt complet par l’ESA.

CÉRÈS :.UNE EXPLICATION POUR LES NOMBREUX BRIGHT SPOTS.

(02/01/2018)

Depuis son arrivée en Mars 2015, la sonde Dawn de la NASA a

examiné Cérès sous toutes ses coutures.

Au lieu d’être une planète naine bien sombre et bien calme, on

s’aperçoit de plus en plus de son activité.

On a détecté plus de

300 points brillants

(les bright spots) à sa surface, on en voit une grande partie sur la carte

ci-dessous.

Position de ces bright

spots sur Cérès (on les nomme officiellement de leur nom latin faculae).

Les scientifiques les

ont divisées en 4 catégories (voir plus loin dans le texte)

Crédit:

NASA/JPL-Caltech/UCLA/MPS/DLR/IDA/PSI/Caltech

Ces zones brillantes qui ont tant étonné les scientifiques, sont

en fait la révélation

d’une activité passée (et peut être encore présente) de l’action d’un

océan interne situé sous la surface.

C’est en tout cas ce que viennent d’annoncer des astronomes du

Caltech, et notamment Carol Raymond, une des PI de la mission, lors de la

dernière réunion de l’AGU (American Geographical Union) en décembre dernier.

Ces bright spots (dépôts brillants) seraient répartis en 4

catégories :

·

Le premier groupe comprendrait les zones les plus

réfléchissantes, celles que l’on trouve au fond des cratères (en rouge sur la

carte ci-dessus).

L’exemple typique est le

cratère Occator bien connu (près de 100km de diamètre) qui contient deux

zones brillantes : Cerealia Facula

au centre, c’est le pic central large de 10km, et Vinalia facula sur le côté.

Le matériau constituant ces points brillants est composé de minéraux riches en

sels, probablement mélangés avec de l’eau dans le passé (sorte de saumur).

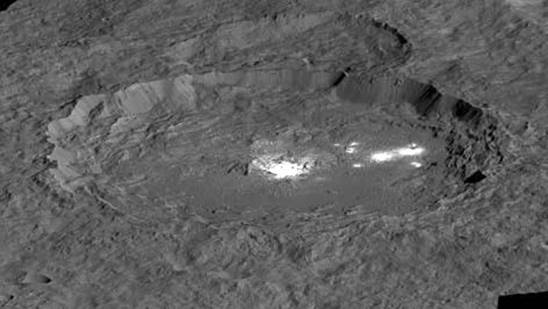

Cratère Occator : crédit : NASA/JPL-Caltech/UCLA/MPS/DLR/IDA

Occator : Dieu romain du hersage !

Une

autre belle vue.

·

La seconde catégorie, correspond au matériau

brillant que l’on trouve sur

les bords des cratères

et s’épanchant vers le fond de ceux-ci. Ce sont des impacts qui ont exposé ainsi

le matériau brillant situé sous la surface. En vert sur la carte.

·

Le troisième groupe comprend le

matériau éjecté

lors de la formation de cratères. En bleu sur la carte.

·

La dernière catégorie est uniquement consacrée à

un seul phénomène exceptionnel : la

montagne brillante

Ahuna Mons. On peut voir sur cette photo une vue d’ensemble de ce mont avec

les

alentours en perspective. La même en

topographie couleurs. On pense très fortement que ce phénomène provient de

cryovolcanisme formé par l’accumulation de glace sur ses flancs.

Au cours du temps, le matériau brillant s’est mélangé avec la

croute de Cérès pour donner un matériau de couleur grise dans la plupart des

endroits. Cette matière brillante est composée de différents sels provenant de

l’intérieur et transportés par l’activité de la planète vers la surface, donnant

ainsi ces points brillants.

Occator serait un peu exceptionnel, dans le sens que l’on pense

qu’il était dans le passé situé sous un réservoir d’eau salée. Le pic central

aurait pu être recouvert de ce dépôt salé lorsque le liquide a remonté en

surface dû à des émanations de gaz lors de l’arrivée en surface (effet champagne

d’après nos amis US !).

Une autre possibilité est l’impact d’un corps important

(astéroïde ?) qui a fait remonter la matière du sous-sol.

Bref tous ces indices semblent aller tous dans la même

direction : Cérès avait

(et a peut-être) toujours un océan interne d’eau salée (plus de la

saumure que de l’eau de mer !).

Une vidéo de la NASA qui explique tout :

Une autre plus courte et claire aussi :

https://www.youtube.com/watch?v=HnukjzYLljU

POUR ALLER PLUS LOIN :

The formation and evolution of

bright spots on Ceres, article de base correspondant à cette

nouvelle.

Bright Areas on Ceres Suggest

Geologic Activity,

article de la NASA

Dwarf Planet Ceres' Bright Spots Suggest an Ancient Ocean de Space.com

Site de la mission au

JPL.

Site de la mission à la NASA.

ARIANE 6 :.DU NOUVEAU : DES MOTEURS ET DES DÉCISIONS.

(02/01/2018)

Nous avons souvent évoqué la nouvelle

génération d’Ariane, Ariane 6,

dans ces colonnes.

De plus en plus sous pression à cause des nouveaux concurrents

privés américains (comme SpaceX ou Orbital ATK ou …), Arianespace (maintenant

ArianeGroup : Airbus et Safran à 50-50) poursuit le lancement en production de

son nouveau lanceur, Ariane 62 (avec deux boosters) de la série Ariane 6.

Vue d’artiste d’une Ariane 62 (crédit ASL)

On vise un lancement depuis Kourou pour la mi-Juillet 2020.

Mais il faut aussi utiliser les Ariane 5 restantes, aussi en

2020, il n’y aura qu’un lancement Ariane 6 et quatre lancements Ariane 5.

L’année suivante les Ariane 64 devrait être lancées.

On espère obtenir des prix de lancement

diminués de moitié

avec Ariane 6 par rapport à Ariane 5.

La

diminution des coûts viendra aussi dans le futur, du nouveau moteur :

le Prometheus, acronyme pour Precursor Reusable Oxygen METHan cost Effective

Engine, ce qui signifie : moteur démonstrateur réutilisable à Oxygène et

Méthane.

La

diminution des coûts viendra aussi dans le futur, du nouveau moteur :

le Prometheus, acronyme pour Precursor Reusable Oxygen METHan cost Effective

Engine, ce qui signifie : moteur démonstrateur réutilisable à Oxygène et

Méthane.

En effet le Méthane va remplacer l’Hydrogène liquide.

ArianeGroup vient de signer un contrat pour ce futur moteur avec

l’ESA, pour une fabrication des deux premiers exemplaires.

Ce moteur devrait être

opérationnel vers 2030

pour les nouvelles versions d’Ariane. Il devra remplacer à terme le moteur

Vulcain2, son coût devrait être 10 fois plus faible

Illustration : crédit : ASL (Airbus Safran Launchers).

L’objectif est d’être en mesure de produire de futurs moteurs à ergols liquides

pour un coût unitaire d’environ 1 million d’euros, soit 10 fois moins que le

coût de production d’un moteur actuel du type Vulcain®2.

La

réussite d’un tel défi technologique repose sur une conception résolument

nouvelle et sur l’utilisation de méthodes et de moyens innovants de conception

et de production.

Au-delà du changement de la filière traditionnelle d’ergols d’Ariane (passage du

couple oxygène et hydrogène liquides au couple oxygène liquide et méthane), le

démonstrateur apportera des évolutions majeures, dont la digitalisation du

contrôle et du diagnostic moteur, ou encore la production par impression 3D,

dans un environnement d’usine connectée. (document Safran)

Premiers essais : 2020.

Cela suffira-t-il à jouer dans la même cour que nos adversaires

US et bientôt Chinois ou Indiens ?

L’avenir nous le dira !

POUR ALLER PLUS LOIN :

ArianeGroup signe avec l’ESA un contrat pour le futur moteur Prometheus

Les Ariane 6

chez ArianeGroup.

Bienvenue sur la chaîne de montage d'Ariane 6, le futur lanceur européen de

l’Usine Nouvelle.

Début de mise en production pour Ariane 6, par la chronique spatiale.

Le Cnes et ArianeGroup préparent le futur d'Ariane 6 par Pif d’Air et

Cosmos.

Pourquoi Ariane 6 reste la meilleure arme face à SpaceX de Challenges. On

peut quand même se poser la question !!!

Ariane 6 :

C’est vraiment parti !: (07/12/2014)

Ariane 6 par l’ESA.

Ariane 6 s'élancera dans 1500 jours, article de Sciences et Avenir.

Le projet de lanceur Ariane 6 a atteint son point de non retour, article du

Figaro.

Ariane 6 sera fabriquée à l'horizontale, article du Figaro.

VU

D'EN HAUT :.TOULOUSE

(02/01/2018)

Le satellite de l’ESA de la série Copernicus, Sentinel-2A, a pris

cette vue (clic sur l’image pour une vue complète HR) de la région de Toulouse.

Région célèbre pour l’aéronautique et maintenant pour l’espace.

C’est à Toulouse que l’on trouve la fameuse Cité de l’Espace que

je vous recommande absolument de voir.

Toulouse est traversée par la Garonne, elle est surnommée, la ville rose, je

pense à cause de la couleur des tuiles de ses toits.

On

remarque l’aéroport de Toulouse Blagnac et de l’autre côté de la Garonne, le

CNES et la Cité de l’Espace.

Copyright contains modified Copernicus Sentinel data (2017), processed by ESA,

CC BY-SA 3.0 IGO

DISPARITION : ALAIN SOUCHIER NOUS A QUITTÉS.

(02/01/2018)

Nous sommes au regret d’annoncer la mort d’Alain Souchier,

fondateur et président de l’association

Planète Mars, le 13 dec 2017 à l’âge de 70ans.

Il se consacrait complètement à son association et donnait des

conférences dans tous les coins de l’Hexagone.

C’était aussi un vrai spécialiste de l’espace, spécialiste de la

propulsion de fusées (expérience à la SNECMA).

Il doit se balader sur Mars maintenant, faisant ainsi aboutir

enfin son rêve….

UN SITE

INTERNET À DÉCOUVRIR :.GALERIE IMAGES DU JOUR DE LA NASA.

(02/01/2018)

(Ce paragraphe est le vôtre si vous avez un site astro à nous

faire connaître, n'hésitez

pas

à nous contacter)

Voici un superbe site d’images astronomiques, le site de la

galerie des images du jour publiées par la NASA.

Visitez-le et mettez-le dans vos favoris.

https://www.nasa.gov/multimedia/imagegallery/iotd.html

https://www.nasa.gov/multimedia/imagegallery/index.html

On peut aussi rechercher une image bien spécifique sur la banque

d’images de la NASA :

Bonne Lecture à tous.

C'est tout pour aujourd'hui!!

Bon ciel à tous!

JEAN PIERRE MARTIN

Abonnez-vous gratuitement aux astronews du site en envoyant votre e-mail.

Astronews précédentes :

ICI

Pour vous désabonner des astronews :

cliquez ICI.